Drei Besonderheiten seien aus der alltäglichen Liste von Meldungen der Klimatologen und Klimaskeptiker herausgepickt:

Die US-amerikanische staatliche Energie-Informationsbehörde EIA befürchtet in einem aktuellen Bericht einen weltweiten Anstieg der CO2-Emissionen von 29 Milliarden Tonnen im Jahre 2006 auf über 40 Milliarden Tonnen im Jahre 2030, wenn von gegenwärtig bestehenden Gesetzen und Regulierungen ausgegangen wird.

|

| Die Prognose der weltweiten CO2-Emissionen bis 2030. |

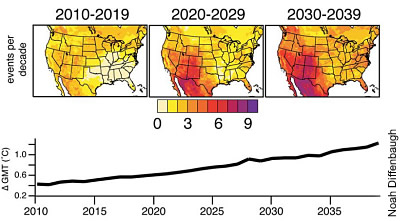

Eine Gruppe um den Klimawissenschaftler Noah Diffenbaugh von der Purdue University in Indiana berechnete erstmals die Klimaänderungen in den USA in hoher Auflösung und sagt extreme Temperaturen für den nordamerikanischen Westen voraus.

|

| Die Prognose extremer Hitzeperioden für die USA bis 2040. |

Die Permafrostböden der Erde speichern etwa doppelt so viel CO2 wie sich aktuell in der Atmosphäre befindet (Schuur, E. A. G. et al. Bioscience 58, 701– 714 (2008)) und fungieren so als gefährliche Zeitbombe. Laut einer aktuellen Arbeit von Edward Schuur und Kollegen von der University of Florida könnte das Tauen in den arktischen Regionen der Erde bis zum Ende des Jahrhunderts Milliarden Tonnen von CO2 freisetzen.

|

| Die Verteilung der Permafrostböden auf der Norhalbkugel der Erde. |

Bis jetzt versucht man die steigende Temperatur der Erde auf den Ausstoß von CO2 in Folge des immer höheren Verbrauchs von fossilen Brennstoffen zurück zu führen. Es ist unbestritten dass dieser Verbrauch explosionsartig gestiegen ist und mit dem Verbrauch die Zerstörung des Ökosystems der Erde besorgniserregenden Stand erreicht hat.

Sind die Ergebnisse der Messungen aber tatsächlich mit diesem simplen Zusammenhang erklärbar?

Schauen wir uns den folgenden Link an.

http://geoweb.princeton.edu/people/b…_2003_copy.pdf

Es beschreibt die Messungen des Verhältnisses zwischen Argon und Distickstoff. Argon ist ein Edelgas und nimmt an keinen chemischen Prozessen teil. Es ist als ein exzellenter Vergleichsparameter um die Schwankungen von CO2 zu beurteilen. Würden sich die beide ähnlich verhalten ist es wahrscheinlich, dass der gleiche physikalische Prozess dahinter steckt. Die Beobachtung zeigt, dass die gemessenen Werte schwanken und zwar übereinstimmend mit der Schwankungen von CO2. Auf der Grundlage der herrschender Doktrin ist dass auf die Löslichkeit des Argon in dem Wasser des Ozeans zurückgeführt bzw. auf die Unterschiede die durch Temperaturschwankungen verursacht sind. Wir haben also ähnliche Schwankungen und zwei verschiedene Interpretationen für deren Ursachen. Schon aufgrund von Ockhams Rasierer ist das mehr als Fraglich.

Die Wissenschaftler wollen hier eindeutig die Realität nicht erkennen weil in anderen Fall die Annahme der anthropogenen CO2- Steigerung nicht mehr zu halten wäre.

Wir könnten uns die Grafik Figure 1 genauer anschauen um diese Vermutung zu überprüfen.

Aus der Annahmen des durch Temperatur gesteuerten Argonaustausch zwischen Ozean und Atmosphäre wurde man schließen, dass die Schwankungen den Jahreszyklen folgen müssen und Richtung Äquator ausklingeln weil dort ganzes Jahr die gleichen Wassertemperaturen herrschen. Wenn wir in der Grafik die Kurve von der Messstation auf der Amerikanischen Samoa (SMO) betrachten sieht alles auf ersten Blick in Ordnung. Bei Genauer Betrachtung stellt sich aber heraus, dass die Werte dort genauso schwanken wie in der Antarktis Bzw. noch ausgeprägter sind. Die würden aber einfach nicht berücksichtigt bzw. hat man denen gleich höhere Unsicherheit zugewiesen und so die Kurve abgeflacht um den gewünschten Effekt bestätigt zu bekommen. In Falle von Barrow in Alaska haben wir ähnliche Situation hier war der Verfasser gezwungen die Kurve so zu gestalten das viele der Werte die nicht zu der Annahme passen einfach nicht berücksichtigt wurde. Ich Frage warum hat er vermieden andere Stationen etwas südlich davon zu berücksichtigen oder solche die weit von dem Ozean liegen und warum wurden die Messungen nicht langfristig geführt. Das sind alles Sachen die uns zeigen mit welchen Methoden und unter Anwendung von welchen Tricks die angebliche „Wissenschaft“ arbeitet.

Oder werfen wir unseren Blick auf die Radon Werte und den Verhalten von diesem schwersten Edelgas. Die Messungen sind leider auf die Jahre 2004 bis 2007 begrenzt aber zeigen eindeutig ähnliche Schwankungen wie beim Argon und CO2 (Siehe Link Seite 40)

http://kfs.ftj.agh.edu.pl/~zimnoch/f…trPoltorak.pdf

Oder wenden wir uns dem der Messungen von Krypton85. Es ist ein radioaktives Isotop des Krypton84. Man nimmt an, dass dies Edelgas durch menschliche Aktivitäten in die Atmosphäre gelang. Wenn man aber die Kurve (oder besser gesagt die Gerade) seit 1976 betrachtet, dann ist diese Entwicklung kaum von der Entwicklung für CO2 zu unterscheiden

Siehe Link Seite 38

http://www.climate.unibe.ch/main/the…gi04diplom.pdf

Wir sehen hier auch die jährlichen Schwankungen und ein beständiges Wachstum des Gehaltes in der Atmosphäre, obwohl eine Kumulierung des Gases aufgrund des radioaktiven Zerfalls nicht möglich ist.

Alle Messungen von Gasen die schwerer sind als Luft werden den gleichen Verlauf aufweisen. Nur in arktischen Bereichen würde sich die Temperatur in dem flachen Verlauf der Kurven niederschlagen. Die maximalen Werte werden immer in Januar gemessen und die minimalen in Juli (sei denn die Vereisung des Bodens den Austritt der Gase behindert oder die niedrigen Temperaturen den Gleichgewicht zwischen Ozean und Atmosphäre verändern). Dieser Verlauf korrespondiert mit dem Verlauf der Änderung der „Gravitationkonstante“. Genauso wie er auch mit dem Verlauf von der Länge des Tages korrespondiert

http://de.wikipedia.org/w/index.php?…20060103000048

Die Gründe für den so genannten Anstieg des CO2- Gehalts liegen in erster Linie in einem falschen Verständnis der physikalischen Prozesse durch den Physiker selbst und zum anderem in der Ignorierung von Veränderungen der Masse des Internationalen Kilogrammprototyps.

Weil seit mehr als 100 Jahren die Gravitationskonstante zunimmt werden auch die Oszillationen der Gasmoleküle in der Atmosphäre immer stärker und parallel dazu auch die Masse des Internationalen Kilogrammprototyps. Siehe Link

http://www.cwirko.de

Pdf-Datei „Gravitation“ Absatz 4/5

Den Gehalt von CO2 hat man auf dem chemischen Wege seit ca. 1812 regelmäßig gemessen aber erst seit der Einführung der physikalischen Methoden hat man eine steigende Tendenz festgestellt. Diese Methode wurde nicht auf Ihre Richtigkeit geprüft. Man hat die Richtigkeit angenommen ohne zu achten, dass diese Methode von der Definition des Kilogramms völlig abhängig ist und nur dann richtige Ergebnisse liefert wenn Kilogramm seine Waage nicht verändert.

Die Frage ist warum sind die Fehlermessungen entstanden?

Bei Herstellung von Referenzgasen wird CO2 zugegeben den man in dem festen Zustand wiegt womit es mit dem Fehler der Masse des Urkilogramms behaftet wird. Diese Fehler in einer Größenordnung von 0,0001 Gramm entstanden durch die Herstellung des Internationalen Kilogrammprototyps bei dem anderen Wert der Gravitationskonstante als Heute. Verflüssigt man heute ein Gas wird er seine Atome enger aneinander binden als vor 120 Jahren. Diese enge Bindung verringert aber die Oszillationseigenschaften der Flüssigkeit und so auch die Wage. Die Gleiche Anzahl der Atome wiegt weniger als vor 120 Jahren. Oder anders gesagt in dem gleichen Volumen werden sich jetzt mehr Atome befinden als vor 120 Jahren. Werden sie wieder in den gasförmigen Zustand gebracht wird der Fehler der von dem Fehler des Urkilogramms stammt um den Faktor ca. 1000 noch vergrößert. Das liegt daran dass der GH auf ein Volumen von ca. 1000 mal größeren Volumen wirkt als in der flüssigen Form (ein m³ Luft wiegt ca. 1 Kilo). Eine Analyse der Luft an dem chemischen Wege ist immer noch die beste Methode den fast tatsächlichen Gehalt des CO2 zu ermitteln. Der Fehler, der von dem Urkilogramm stammt ist dann nicht so bedeutend als bei Methoden mit Phasenübergängen der Referenzgase. Die physikalischen Methoden sind Irreführend sobald man den Drift der Masse des Urkilogramms und den Normalen ignoriert.

Die Änderungen des Wertes der „Gravitationskonstante“ sind für das Wetter verantwortlich. Die langfristigen Änderungen der Stärke bewirken dann die Änderungen des Klimas der Erde.

Ich sehe folgenden Mechanismus wie die Gravitative Wirkung eine Erwärmung der Atmosphäre verursacht:

Wie ich schon mehrmals erklärt habe Gravitation ist nicht eine Eigenschaft der Masse sonder entsteht durch Beschleunigung der Materie durch GH. Auf Grund der Interferenz kommt es bei der Materiekörper zu einer Verstärkung der Raumoszillationen wobei nur die Oszillationen Richtung Messezentrum erfahren konstruktive Interferenz. Die Oszillationen in andere Richtungen löschen sich destruktiv gegenseitig aus.

Im Endeffekt ist ein Materiekörper eine Art der Verstärker der Raumoszillationen des GH.

Jede Körper ist dann die Quelle von eigenen Raumoszillationen.

In unserem Sonnensystem entsteht durch aussenden solcher Raumoszillationen durch einzelne Himmelskörper ein komplizierter Muster aus Bereichen in denen eine konstruktive oder destruktive Interferenz stattfindet.

Die Erde bewegt sich in so einem Feld und ist ständig diesen Änderungen ausgesetzt.

Das äußert sich dann in Form von geringfügigen Schwankungen des Wertes der „Gravitationskonstante“.

Steigt der Wert des GH langfristig dann wird die Atmosphäre wärmer. Die Klima Erwärmung hat als gar nicht zu tun mit dem CO2 sonder ist alleine auf die Steigerung des Wertes der Gravitationskonstante zurückzuführen. Der Mechanismus der zu Erhöhung der Temperatur der Atmosphäre führt sieht so aus.

Die Wassermoleküle gehen in Gasförmige zustand über. In diesem Moment Oszillieren sie nur so schwach dass das gerade ausreicht um die Oberflächenspannung des Wasser zu überwinden. In Gasförmigen Zustand könnten sie jetzt „Energie“ von den GH aufnehmen und werden auf die typischen Geschwindigkeiten der Gasmolekülen beschleunigt. Dieser Wasserdampf steigt dann mit Luftmassen in die Höhe. Mit jedem Meter nach oben werden die Oszillationen dieser Moleküle geringer weil auch die Oszillationen des GH schwächer werden so dass dann zu einer Kondensation des Wassers kommt. Die vorher aus dem GH aufgenommene „Energie“ wird jetzt als Wärme Abgegeben. Je Stärker der GH in diesem Moment ist desto Enger werden die Moleküle zusammengebunden und damit die Wärmeausbeute größer.

Es gibt auch ein einfaches Experiment der Möglicherweise meine Sichtweise bestätigen kann. Aus meiner Hypothese geht es heraus, dass der GH der Abstand der Moleküle beim Gefrieren vom Wasser reguliert. Genauso wie in dem Fall des Urkilogramms ergibt sich eine Unterschiedliche Empfindlichkeit des Eises auf die Oszillationen des GH und entsprechen seine Masse. Werden wir eine dicht geschlossene Probe des Eises von einem Alter sagen wir ca. 20000 Jahre präzise wiegen und dann schmelzen lassen dann mal einfrieren und wiegen. muss sich ein Unterschied in dem Gewicht vor dem Schmelzen und nach dem Schmelzen zeigen.

Diese Unterschied entspricht dann genau dem Wertunterschied der „Gravitationskonstante“ zwischen jetzt und vor 20000 Jahren.

Wir könnten überhaupt erst dann die Frage zu den Ursachen des steigenden Gehaltes des CO2 stellen, wenn wir solche Untersuchungen wie vor mir vorgeschlagenen durchführen und auswerten ohne die Scheuklappen der modernen Physik.

So ist diese ganze Diskussion über CO2 Anstieg eine leere Gerede und in seinem Sinn nicht von Solcher über Anzahl der Teufel an der Spitze der Nadel unterscheidbar

Eigentlich sollte man 2 Messer anwenden, eines, um den Kommentar zu kürzen, das andere nach Ockhams Art.

Die Links scheinen nicht zu funktionieren. Anbei die richtigen:

http://geoweb.princeton.edu/people/bender/lab/downloads/Battle_et_al_2003_copy.pdf

http://kfs.ftj.agh.edu.pl/~zimnoch/files/mgr/PiotrPoltorak.pdf

Der Link für Krypton85 funktioniert nicht. Wahrscheinlich hat der Betreiber der Seite diese Publikation gelöscht. Als Ersatz hier eine Seite wo auf dem Abbildung 3 die zeitliche Entwicklung des Kryptons85 dargestellt wurde

http://www.hydroisotop.de/index.php?option=com_content&task=view&id=11&Itemid=49

http://de.wikipedia.org/w/index.php?title=Datei:LengthOfDay_1974_2005.png&filetimestamp=20060103000048

Ich habe in meinem vorherigen Beitrag vor einer möglicherweise falschen Interpretation der C0²- Messungen in Folge der Verwendung der physikalischen Messmethoden gewarnt.

Es ist aber nicht nur C0² der falsch gemessen wird, sondern es ist nur ein Beispiel vom vielen. Im Grunde genommen basiert die heutige Physik auf solchen Falschmessungen wo den Beteiligten nicht bewusst ist was sie messen und wie weit die Ergebnisse eine Aussagekraft haben.

Die Klimatologie ist hier ziemlich in einer „unglücklicher“ Situation, weil sie im Gegenzug zu z.B. Astrophysik mit dem Objekt der Forschung ständig konfrontiert wird.

Trotzdem es ist schon unglaublich, dass die beteiligten Wissenschaftler (mehrheitlich ausgebildete Physiker) nicht bemerkt haben, dass die Messungen falsch sind und ein grundsätzlicher Problem dahinten steckt, besonders, dass nicht nur C02-Werte falsch gemessen wurden, sondern auch Temperaturen.

Hier ein Link zu der Verlauf der Temperaturen gemessen von MeteoSwiss.

Man hat versucht auf der Basis der herrschenden Glaubens in der Physik die Werte von „schädlichen“ Einfußen zu bereinigen (ohne Sinn und Verstand) was zu noch größeren Fehlern geführt hat. Wie man auf den ersten Blick sieht führt diese Vorgehensweise zu künstlichen Steigerung der Temperaturen in den homogenisierten Daten im Vergleich zu den Rohdaten.

http://www.meteoschweiz.admin.ch/web/de/klima/klima_heute/homogene_reihen.Par.0054.DownloadFile.tmp/vergleichoriginalhomogen.pdf

Es stellt sich die Frage ob hier eine reale Situation abgebildet wurde oder die vorgenommenen Eingriffe in die Daten einen falschen Verständnis der physikalischen Ursachen zu Grunde liegen.

In dem folgenden Link,

http://noconsensus.wordpress.com/2009/12/15/swiss-homogenization/

in dem Kommentar Nr.37 ist eine Stellungsnahme des MeteoSwiss zu lesen in dem die Gründe der Homogenisierung der Temperaturmessungen benannt wurden.

Zum Einen standen in den ersten Jahrzehnten der ausgewerteten Messperiode (bis ca. 1900) Thermometer im Einsatz, bei denen es oft zu einer langsamen Kontraktion des Quecksilbergefäßes kam, was zu einer “Zunahme” der Temperaturmessungen um 0.5 bis 1 Grad über mehrere Jahre bis Jahrzehnte führte. Dies musste systematisch korrigiert werden.

Zum Anderen wurden Ende der 1970er Jahre viele Stationen automatisiert. Die Messung mit ventilierten Thermometern führte zu einer geringeren Beeinflussung durch die Sonnenstrahlung und resultierte in systematisch tieferen mittleren Messwerten (verstärkt noch im Sommer).

Waren aber die vorgenommenen Veränderungen der Daten gerecht?

In dem ersten Fall bis ca. 1900 (ich nehme an, dass bei einzelnen Messstationen Quecksilberthermometer noch viel länger in Gebrauch waren) wurde festgestellt, dass mit der Zeit die gemessene Temperatur bzw. der Nullpunkt des Thermometers nicht mehr mit dem Schmelzpunkt des Eises stimmt. Damals wurden noch tatsächlich Thermometer nach Fixpunktverfahren kalibriert. Man hat festgestellt dass die Thermometer mit der Zeit immer höhere Temperaturen anzeigen und hat fälschlicherweise angenommen, dass die Ursache in der Verringerung des Volumens des Quecksilbergefäßes liegen muss. In Wirklichkeit zeigte hier der gleiche Prozess ihre Wirkung, der zu der Erhöhung der Masse des Urkilogramms geführt hat nämlich die Steigerung der Amplitude der Raumoszillationen, die für uns auch durch die Steigerung des Wertes der Gravitationskonstante sich bemerkbar macht. In Folge dessen werden auch die Oszillationen der Elementarteilchen größer was bei der Materie in dem gasförmigen und flüssigen Zustand zu Volumen Vergrößerung geführt hat.

Diese Volumenvergrößerung war im Grunde genommen sehr klein aber sie hat sich durch die verstärkende Wirkung der Kapillare bemerkbar gemacht.

Die Temperatur hat sich also in allen diesen Jahren kaum merklich verändert aber erst durch Homogenisierung und Verschiebung der gemessenen Werte um 1 Grad Celsius nach unten wurde hier ein Trend in der Entwicklung der Temperaturen künstlich erschafft.

In dem Zweiten Fall hat man schon wieder etwas bemerkt aber wie immer bei Physiker falsch bewertet.

In den modernen meteorologischen Messstationen werden keine altmodischen Ausdehnungsthermometer mehr verwendet sonder die so genante Widerstandsthermometer die eine Automatisierung des Messvorgangs ermöglichen.

Widerstandsthermometer sind elektrische Bauelemente, welche die Temperaturabhängigkeit des elektrischen Widerstandes von Leitern zur Messung der Temperatur ausnutzen. Platin-Widerstandsthermometer die meistens Verwendung finden werden im Vergleichsverfahren kalibriert.

Dazu werden Normalthermometer verwandet die ihrerseits auf die nationale Normale rückgeführt werden müssen. Diese Vorgehensweise die die Fehler eigentlich ausschließen sollte ist aber paradoxerweise der Grund warum die Temperaturen bei Langzeitreihen falschen Trend aufweisen.

Man hätte es Ahnen müssen aber die autistische Denkweise der „Wissenschaftler“ erlaubt eine selbstkritische Begutachtung eigenen Denkens nicht (vorausgesetzt so etwas wie Denken ist in der „Wissenschaft“ existent).

Es ist bekannt, dass die Platin-Widerstandsthermometer einen Hystereseeffekt zeigen, d.h. der Zusammenhang zwischen Temperatur und Widerstand wird durch mechanische Spannungen verändert. Das kann zu einem Unterschied in der Anzeige von bis zu 0,5 K führen. Das heißt der Einfluss der Veränderung der atomaren Struktur des Platins war bekannt.

Hat man also festgestellt, dass die Veränderung der Anzeige der Widerstandsthermometer einen Trend zeigt sollte man in erster Linie diese Veränderung auch bei der nationalen Normalen annehmen.

Stattdessen wurde die nationale Normale für Sakrosankt erklärt.

So etwas aber wie ein absolut beständiger Wert einer Messgröße existiert in unserem Universum einfach nicht. Mit der Veränderung der Amplitude der Raumoszillationen verändert sich auch der Widerstand der nationalen Normale. Und zwar stärker als der meisten Widerstandsthermometer. Der Grund liegt in dem Zeitpunkt des Gießvorgangs des Ausgangsmaterials und der lag in dem Zeitpunkt wo „Gravitationskonstante“ geringer war. Beim Festwerden des Metals wurden die Atome nicht so eng gebunden als in den Später angefertigten Thermometer. Folglich reagierten sie dann stärker auf den weiteren Zuwachs des GH und oszillierten entsprechend stärker. Das ist nichts anderes als ob die Normale eine Höhere Temperatur hätte. Die später gefertigte Thermometer reagieren nicht so empfindlich weil bei denen die Atome enger gebunden wurden. Die zeigen also dann immer zu niedrige Temperatur.

Bei dem Kalibrierungsvorgang wurde das zwar regelmäßig korrigiert, nach einiger Zeit war der Unterschied schon aber wieder da. So sammelte sich in laufe von 40 Jahren eine durch die Homogenisierung und Statistik verursachte Klimakatastrophe.

Es sind zwei Dinge die Unendlich sind, das Universum und die Dummheit der Physiker, wobei beim Universum bin ich mir noch nicht ganz sicher.

Noch etwas geht gegen unendlich, die Länge der Kommentare von Ireneusz Cwirko.